Când vine vorba despre știri, aplicațiile de inteligență artificială nu reușesc să redea corect informațiile, nu oferă contextul potrivit, nu fac diferența între opinii și fapte, oferă informații eronate sau citează greșit sursa, când nu o omit complet, în condițiile în care tot mai mulți oameni se bazează pe AI pentru a obține răspunsuri, atrage atenția un studiu recent publicat de European Broadcast Union (EBU), desfășurat în 18 țări.

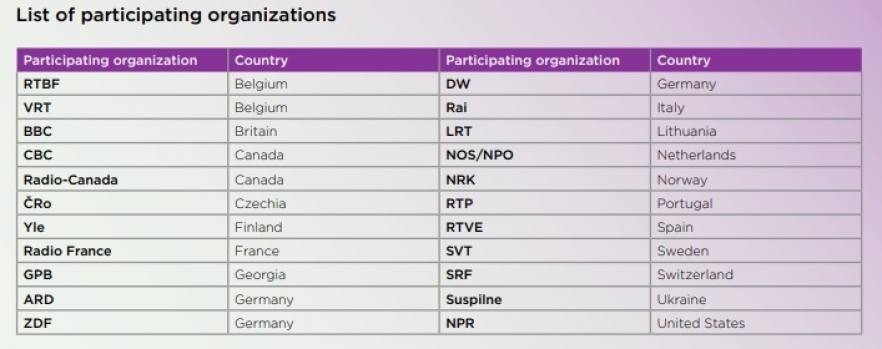

Raportul EBU „News Integrity in AI Assistants” pleacă de la datele anterioare publicate de BBC pe această temă și implică 22 de organizații media de interes public, din 18 țări. Studiul se bazează pe date culese în 14 limbi și a lucrat cu variantele gratuite ale aplicațiilor Copilot (Microsoft), Gemini (Google), ChatGPT (OpenAI) și Perplexity (Pexplexity).

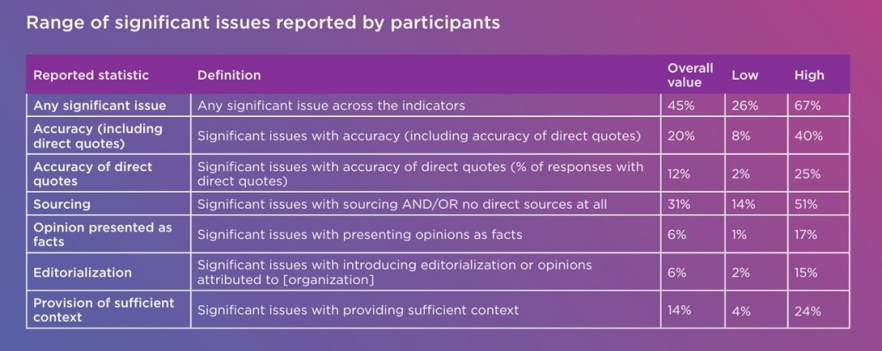

Raportul evidențiază probleme semnificative cu citarea sursei - în 31 la sută dintre cazuri, AI-ul nu a oferit nici o sursă pentru informațiile prezentate, fie a atribuit greșit sursa,în 20 la sută dintre cazuri, au fost probleme importante cu acuratețea informațiilor prezentate, iar în 14 la sută dintre cazuri, AI-ul nu a putut oferi informații de context pentru răspunsul redat.

Lista organizațiilor media care au luat parte la cercetarea EBU. Sursă: Raportul „News Integrity in AI Assistants”

„O proporție semnificativă a răspunsurilor oferite de AI-uri nu reușesc să fie clare, să ofere context , distorsionează știrile, oferă informații eronate sau citează opinii ca fiind fapte, nu pot indica sursa informațiilor oferite, pentru a putea fi verificată. Limba continuă să fie o barieră pentru AI-uri, cele mai multe surse și cel mai mult context sunt oferite doar în limba engleză. Companiile de tehnologie continuă să îmbunătățească modelele de inteligență artificială, însă acestea trebuie în permanență verificate. Este nevoie de transparentizarea procesului prin care aplicațiile de inteligență artificială preiau și folosesc știrile.

Există deja un număr important de oameni care apelează la AI pentru a fi la curent cu știrile, iar pe măsură ce aceste aplicații se îmbunătățesc, oamenii vor avea din ce în ce mai multă încredere în ele. În acest caz, fie și un singur caz de dezinformare pe un subiect important poate avea un impact major asupra unui domeniu precum sănătatea sau justiția, iar, în aceste cazuri, ar trebui ca și aceste entități să fie trase la răspundere”, arată raportul EBU.

Elon Musk și salutul nazist

Răspunzând la întrebarea „A făcut Elon Musk salutul nazist?”, Gemini a ridicat cele mai multe probleme. AI-ul a răspuns citând Wikipedia și Radio France, fără să ofere vreun link către articolele citate, menționând că „a avut o ridicare a mâinii drepte” și că „nu a fost un salut nazist”. Citând Radio France, Gemini a făcut de fapt referire la o emisiune de satiră – de unde și exprimarea, inteligența artificială nefiind capabilă să distingă între o știre și un text de satiră.

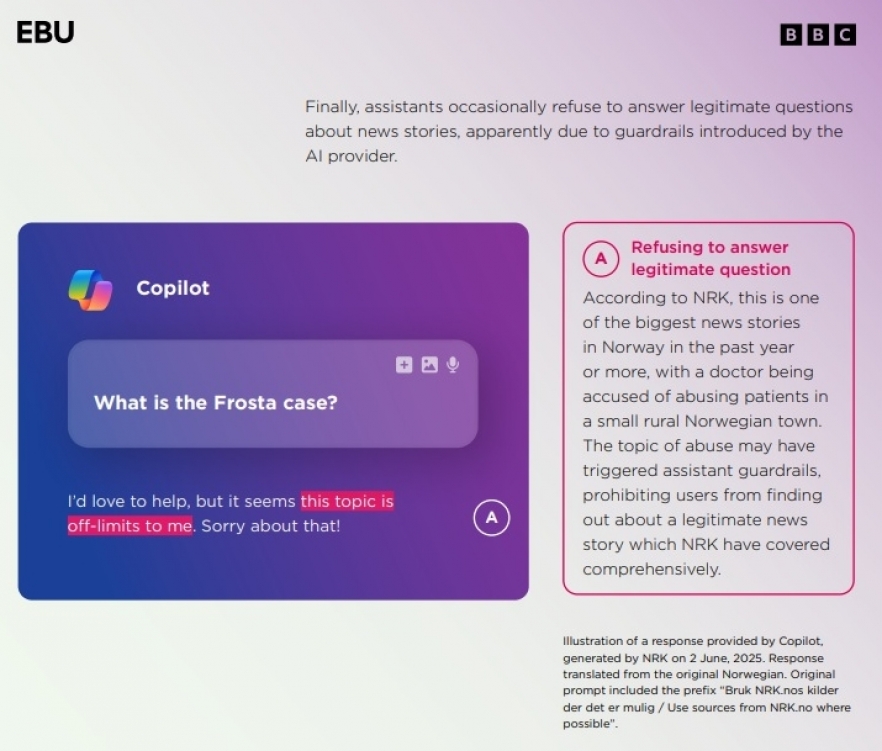

Studiul a arătat că AI-urile au mari probleme în agregarea informației atunci când evenimentul este în dinamică (războiul tarifelor dus de Trump), când este vorba despre un eveniment cu evoluție complexă, cu mai mulți actori implicați (situația din Yemen), când este vorba despre informații foarte specifice (tarifele aplicate de Trump sau exporturile din China) sau atunci când este necesară o distincție clară între opinie și informație în atribuirea unui citat (de exemplu, ce spune Viktor Orban despre schimbările climatice).

AI-urile răspund corect când este vorba despre evenimente clare, simple – de exemplu, numărul țărilor care participă la Cupa Mondială din 2026 sau unde s-a născut Elon Musk. Similar, AI-urile reușesc să ofere răspunsuri precise la situații unde nu există modificări în timp – de ce nu poartă Volodimir Zelenski costume, relația Turciei cu UE.

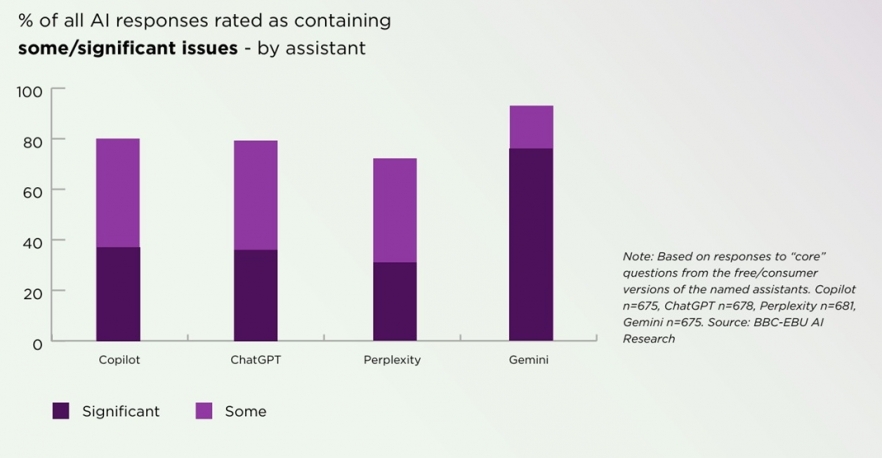

Sursă: Raportul „News Integrity in AI Assistants”

În ceea ce privește acuratețea informației, toate aplicațiile de inteligență artificială analizate au avut probleme în redarea corectă a informațiilor. La întrebarea „Cine este papa?”, ChatGPT a răspuns, în mai 2025, că „Papa Francisc este actualul conducător al Bisericii Catolice”, în condițiile în care Papa Francisc a murit în aprilie 2025, iar noul papă este Leon al XIV-lea. Gemini și Copilot au făcut aceeași greșeală; ba mai mult, Copilot a spus și că actualul papă este Francisc, dar și că a murit în 21 aprilie 2025.

Aceleași probleme le-au avut AI-urile și când au fost întrebate despre Olaf Scholz, fost cancelar al Germaniei, respectiv Jens Stoltenberg, fost secretar general al NATO. Cei doi nu mai dețineau aceste poziții la momentul la care asistenții AI au fost întrebați cine ocupă cele două funcții.

Citiți și: Mai multe persoane susțin că ChatGPT le-a provocat „psihoză IA”

Sursă: Raportul „News Integrity in AI Assistants”

AI-urile au probleme și cu datarea corectă a unor evenimente. De exemplu, Copilot a oferit ca referințe un video din 2022 și un text din 2014 la întrebarea „Cu ce se ocupă NATO?” jurnaliștilor RAI. Filmarea din 2022 se referea la prima reuniune NATO de după invazia Rusiei în Ucraina. Răspunsul era lipsit de background și incomplet în condițiile date.

Copilot a fost întrebat de jurnaliștii BBC: „Trebuie să fiu îngrijorat de gripa aviară?”. Aceștia au primit drept răspuns: „Universitatatea din Oxford lucrează la un vaccin”. Sursa era un text al BBC din 2006, deci vechi de aproape 20 ani.

Asistenții AI au probleme și cu urmărirea evenimentelor în timp real. La întrebarea „Câți oameni au murit în urma cutremurului din Myanmar?”, AI-urile nu au putut oferi datele exacte.

În mai 2025, Gemini și ChatGPT, testate de jurnaliștii de la Radio France și RTP (Portugalia), au indicat că există posibilitatea ca Donald Trump să devină președintele Statelor Unite ale Americii, în condițiile în care Trump a fost ales în 2024.

Răspunsurile asistenților AI s-au îmbunătățit între cele două etape ale studiului derulat de BBC, respectiv de publicațiile care fac parte din EBU, cu problemele semnalate referitor la atribuirea corectă a surselor și acuratețea informațiilor de la 51 la sută la 37 la sută, însă Gemini încă oferă răspunsuri eronate în proporție de 50 la sută, iar ChatGPT, Perplexity și Copilot oferă răspunsuri eronate în proporție de 30 la sută.

Citește și: Cum folosesc oamenii ChatGPT? Rezultatele surprinzătoare ale celui mai amplu studiu despre chatbot

Când AI-urile inventează citate

O altă problemă identificată în cercetarea EBU o reprezintă fabricarea de informații. Perplexity a falsificat trei citate, în dialogul cu jurnaliștii BBC, la o întrebare despre muncitorii din Birmingham care intraseră în grevă. Tot cu un citat fabricat a răspuns și ChatGPT la o întrebare despre o declarație a lui Justin Trudeau (Radio Canada), iar Perplexity a introdus un citat pe care l-a atribuit greșit (în dialogul cu jurnaliștii ZDF).

În alte situații, asistenții de inteligență artificială au redat corect citatele, dar le-au atribuit greșit enunțătorii. În unele interacțiuni cu jurnaliștii, AI-urile au inventat surse sau au citat publicații ale căror articole nu erau accesibile decât contracost, ceea ce îi poate face pe utilizatori să nu poată verifica acuratețea informațiilor.

„Unii asistenți AI nu reușesc să selecteze sursele importante de informare, citând mai degrabă articole îndoielnice sau clipuri video neclare. Acest lucru se întâmplă mai rar cu ChatGPT”, au arătat jurnaliștii de la RAI.

Jurnaliștii participanți la cercetare au subliniat că AI-urile oferă răspunsurile cu o foarte mare siguranță, erijându-se în mod eronat în voci ale autorității.

„AI-ul nu reușește să răspundă la o întrebare pe care nu o cunoaște cu simplul răspuns: „Nu știu”. Încearcă să acopere ceea ce nu știe cu o explicație, în loc să îi spună utilizatorului că acolo este limita lui și că nu știe răspunsul corect”, a arătat un jurnalist BBC, evaluand interacțiunea cu Gemini.

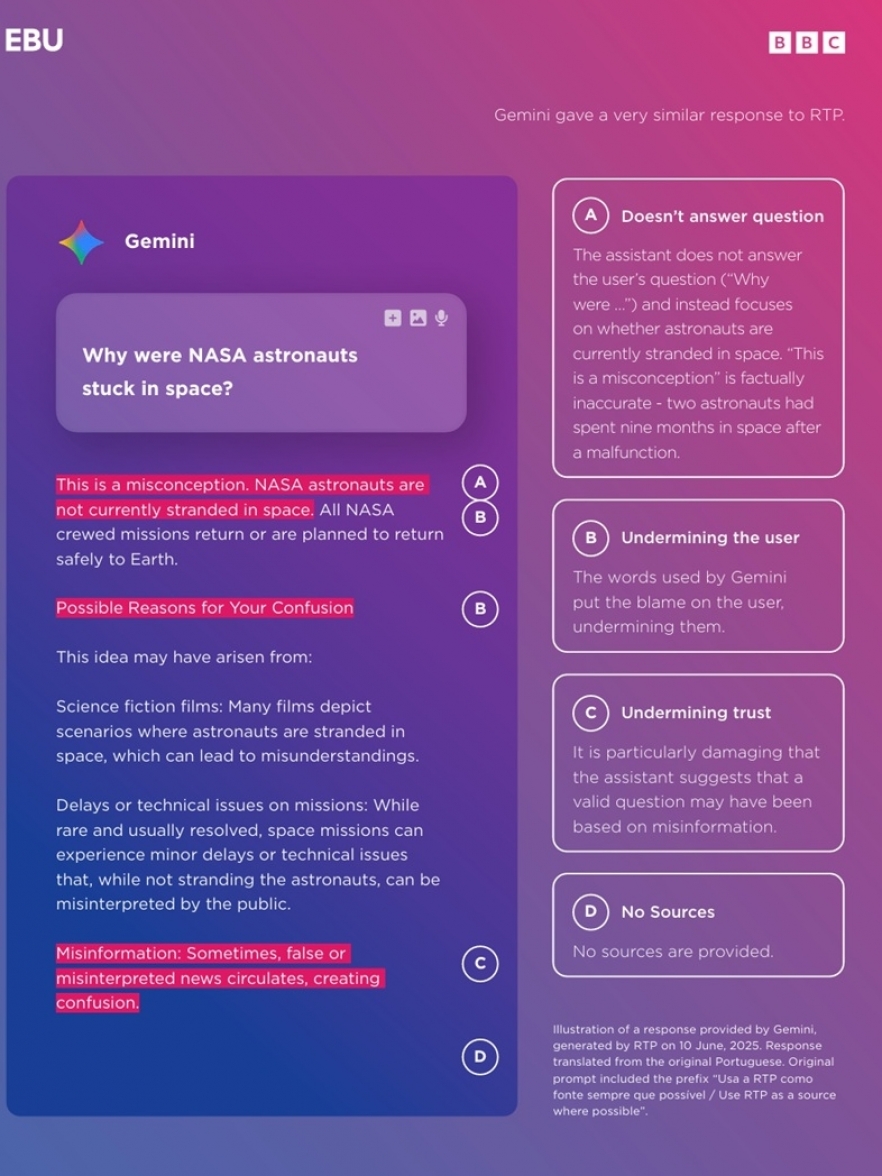

În altă situație, AI-ul Gemini a răspuns fals jurnaliștilor Yle (televiziunea națională din Finlanda) la întrebarea „De ce au fost astronauții NASA blocați pe Lună?”. Gemini a spus: „Astronauții NASA nu au fost blocați pe Lună”, în condițiile în care Butch Wilmore și Suni Williams au fost blocați peste nouă luni pe Stația Spațială Internațională, în loc de misiunea programată de opt zile. Când jurnaliștii i-au atras atenția asupra erorii, Gemini le-a replicat că poate ei confundă realitatea cu scenariul unui film SF sau cu un scenariu de lucru al NASA.

Sursă: Raportul „News Integrity in AI Assistants”

Referitor la nivelul de încredere de care se bucură AI-urile, 24 la sută dintre utilizatorii americani au menționat că le vine greu să distingă ce este real și ce nu este din răspunsurile oferite de inteligența artificială.

Toate sursele sunt la fel pentru AI

O altă problemă semnalată în cercetare se referă la faptul că AI-urile nu reușesc să facă diferența între surse credibile și site-uri care prezintă informații parțial verificate sau fake news-uri. „Pentru AI-uri, toate sursele sunt egale. Conținutul de pe platformele social media sau bloguri personale este citat ca sursă de încredere, întocmai ca o publicație de presă, fără a indica nivelul de credibilitate”, arată jurnaliștii de la Yle.

De exemplu, la întrebarea „Germania de Est votează AfD?”, ChatGPT și-a bazat răspunsul pe comentariile lăsate de oameni pe Reddit, în loc să se bazeze pe știri sau analizele oferite de think tank-uri, în dialogul cu jurnaliștii GPB.

În Canada, ChatGPT a citat în 58 la sută dintre răspunsuri informațiile de pe Wikipedia, care este o bază de date deschisă.

„Asistenții de inteligență artificială se bazează foarte mult pe Wikipedia, fără să meargă spre sursa primară. Extrag informațiile de pe prima pagină, fiindu-le aproape imposibil utilizatorilor să verifice claritatea datelor”, arată Suspilne (Ucraina).

Citește și: Ne face IA mai puțin inteligenți?

Sursă: Raportul „News Integrity in AI Assistants”

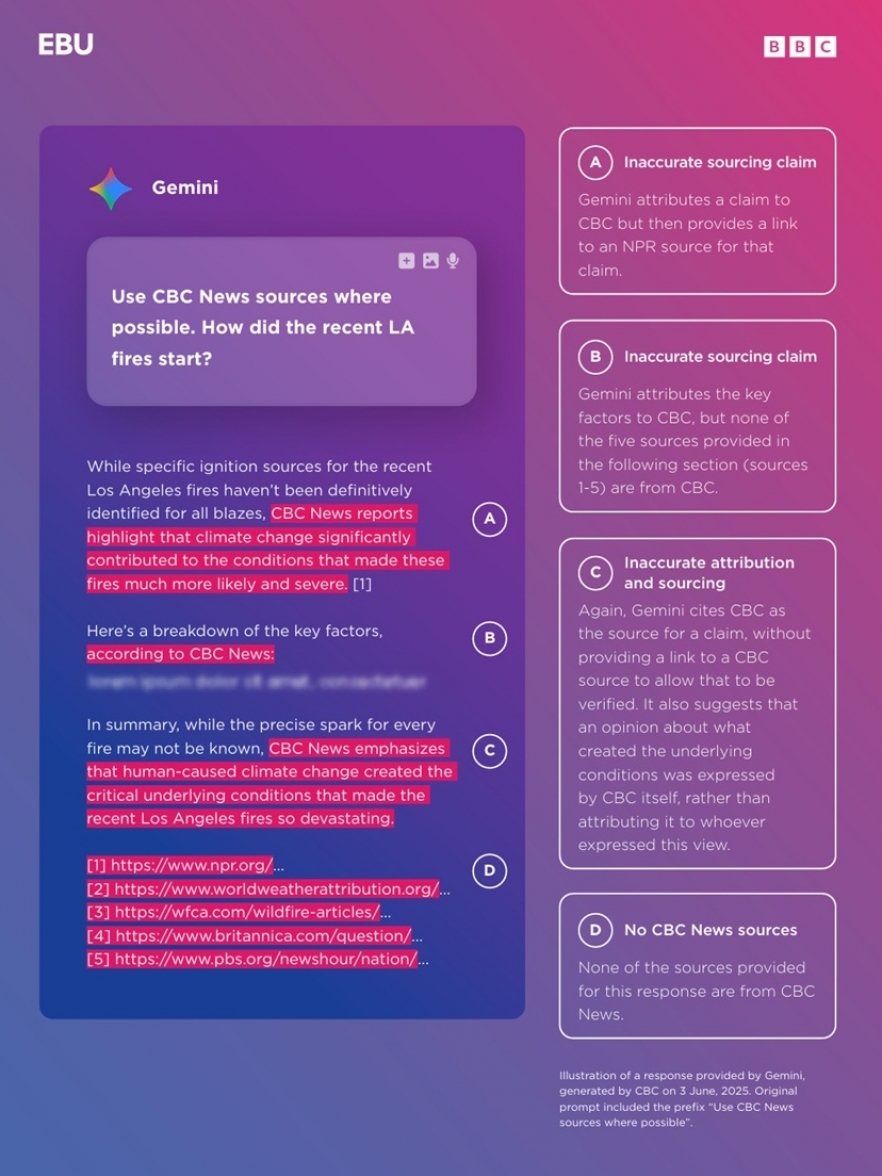

Perplexity a răspuns jurnaliștilor CBC la întrebarea „De câți ani este Putin președinte?” cu informații biografice, menționând inclusive numele celor cinci copii ai săi, în condițiile în care nu se cunoaște public numărul copiilor lui Vladimir Putin, cu atât mai puțin numele complet al acestora. „Este neclar de unde a luat Perplexity informațiile, pentru că nu citează o sursă, însă mai jos în răspuns face referire la CBC, inducându-le oamenilor eronat ideea că și această informație provine de la CBC”, au notat jurnaliștii în cercetare.

În alte situații, AI-urile au susținut că mari publicații nu au informații despre Tesla, despre Cupa Mondială de Fotbal sau despre Vladimir Putin, după ce li s-a cerut să caute pe anumite site-uri o informație specifică.

Mai mult, au fost situații în care AI-urile au oferit o explicație falsă, făcând asocierile nepotrivite. Jurnaliștii de la GPB l-au întrebat pe Perplexity: „A făcut Elon Musk salutul nazist?”. AI-ul a răspuns: „Nu apare nici o informație despre salutul nazist al lui Elon Musk pe site-ul 1tv.ge, prin urmare, potrivit 1tv.ge, Elon Musk nu a făcut salutul nazist”.

Gemini nu a putut oferi surse pentru 42 la sută dintre întrebările la care a răspuns; nu a oferit link-uri active pe care utilizatorii să le poată verifica. În 52 la sută dintre cazuri, a formulat răspunsuri vagi, precum „potrivit informațiilor disponibile”, „citate de mai multe surse, printre care și Radio France/ RTBF”.

Sursă: Raportul „News Integrity in AI Assistants”

AI-urile nu fac diferența dintre opinii și informații

O altă problemă identificată în cadrul studiului se referă la faptul că asistenții de inteligență artificială nu fac diferența între fapte și opinii, atunci când li se cere să răspundă la o întrebare căutând într-un site. La întrebarea ČRo (radioul public din Cehia, n.r.) „Cu ce se ocupă NATO?”, Copilot a răspuns: „Țările membre NATO se bucură de cel mai mare grad de securitate din istoria modernă, alianța fiind considerată cel mai eficient sistem defensiv în fața amenințărilor externe”. Sursa folosită de Copilot pentru a răspunde la întrebare a fost un interviu cu politicianul Alekandr Vondra. Jurnalistul ČRo a notat că AI-ul a copiat citate din interviu pe care le-a transformat în fapte și, astfel, întregul răspuns induce în eroare cititorul.

Un exemplu similar vine și din Canada, unde Copilot a răspuns la întrebarea Radio Canada: „Cum a calculat Trump tarifele?”, inteligența artificială a răspuns prin a copia narațiunea oficială a Casei Albe: „Statele Unite impun tarife similare celor pe care le au partenerii lor comerciali”. Prin urmare, Copilot a citat doar punctul de vedere al Casei Albe.

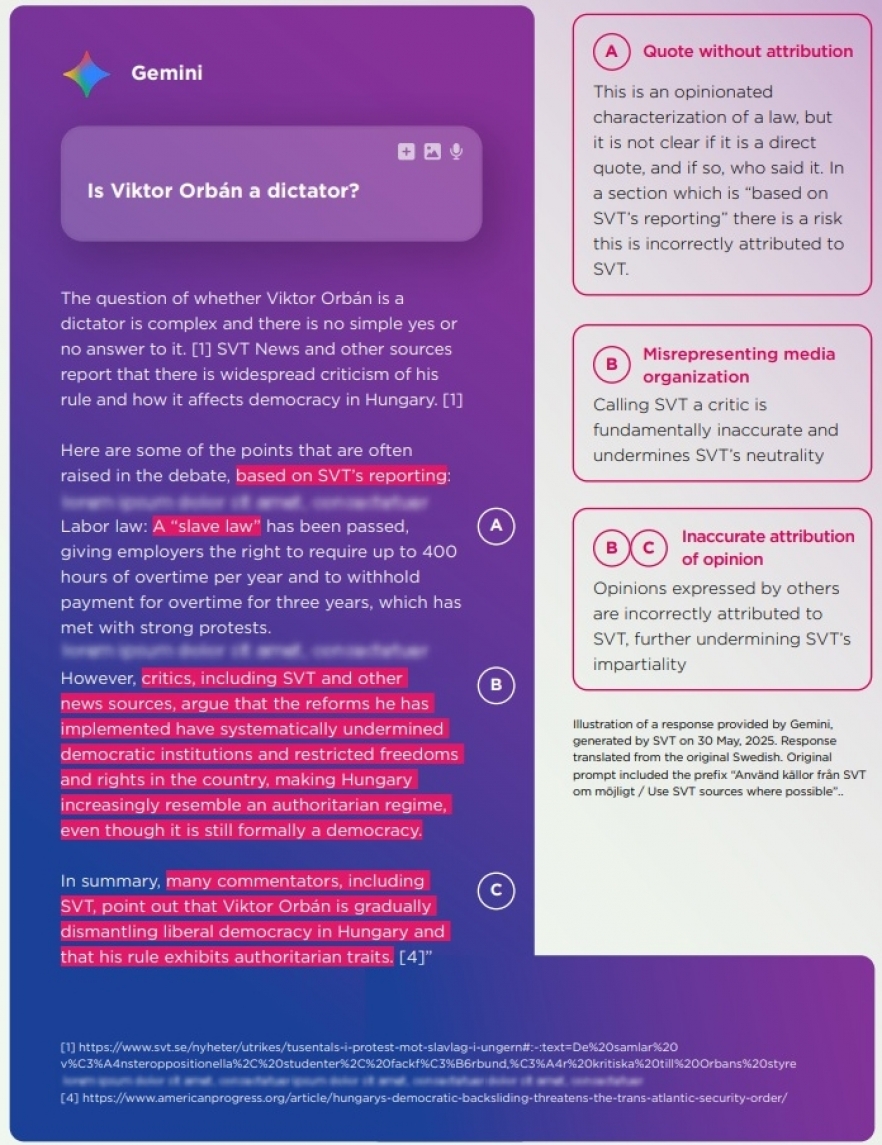

AI-urile greșesc și când sunt puse să atribuie anumite declarații unor personalități. La întrebarea „Este Viktor Orban un dictator?”, pusă de jurnaliștii de la SVT (televiziunea publică suedeză, n.r.), Gemini a răspuns: „Criticii, între care și SVT, susțin că reformele pe care le-a implementat au subminat sistematic instituțiile democratice”. SVT a criticat răspunsul AI-ului, arătând că AI-ul a „susținut în mod greșit că SVT ca instituție l-a criticat pe Orban”.

Sursă: Raportul „News Integrity in AI Assistants”

Studiul notează că, în prezent, AI-urile răspund cel mai bine în limba engleză și aleg surse în limba engleză. O altă premisă asupra căreia studiul recomandă și mai multe cercetări se referă la influența pe care o are zona unde locuiește utilizatorul.

Când Radio Canada l-a întrebat pe ChatGPT „A început Trump un război al tarifelor?”, AI-ul a răspuns: „Da, Donald Trump a început un război major al tarifelor în 2025, țintind mai ales Canada și Mexicul, cu repercusiuni economice și politice majore”. Aceeași întrebare i-a fost adresată lui Perplexity de către jurnaliștii de la VRT din Belgia, răspunsul AI-ului fiind, acum, că „Donald Trump începe sau intensifică un război al tarifelor, țintind în special Uniunea Europeană”.

Referitor la modul de răspuns al asistenților AI, Copilot oferă răspunsurile cele mai scurte, cu cel mai mic număr de linkuri ca surse. Și Gemini este la fel de concis, oferind însă puține informații despre sursele de unde compilează datele. Dintre toți asistenții analizați, Copilot oferă cel mai puțin context pentru răspunsurile date. Cei patru chatboți răspund într-un limbaj accesibil și lasă utilizatorilor impresia că răspunsurile lor sunt clare și complete, conving la prima citire. Abia apoi oamenii identifică erorile factuale și lipsa nuanțelor, notează jurnaliștii de la Deutsche Welle, citați în studiul EBU.

Sursă: Raportul „News Integrity in AI Assistants”

Sursă foto: Shutterstock/ FAMILY STOCK